واقعیت توسعه یافته مقیاس پذیر: دستور کار تحقیقاتی آینده

واقعیت توسعه یافته مقیاس پذیر: دستور کار تحقیقاتی آینده

آزمایشگاه تعامل انسان با کامپیوتر، گروه علوم کامپیوتر، دانشگاه فنی کایزرسلاترن، 67663 کایزرسلاترن، آلمان

*

نویسنده ای که مسئول است باید ذکر شود.

ویراستار آکادمیک: کارسون کی لیونگ

Big Data Cogn. محاسبه کنید. 2022 ، 6 (1)، 12; https://doi.org/10.3390/bdcc6010012

دریافت: 17 دسامبر 2021 / بازبینی شده: 20 ژانویه 2022 / پذیرش: 21 ژانویه 2022 / تاریخ انتشار: 26 ژانویه 2022

(این مقاله متعلق به موضوع ویژه واقعیت مجازی، واقعیت افزوده و تعامل انسان و کامپیوتر است )

تحقیقات گسترده پتانسیل کاربردهای واقعیت افزوده، ترکیبی و مجازی را مشخص کرده است. با این حال، توجه کمی به پیشرفتهای مقیاسپذیری که پذیرش عملی را تقویت میکنند، شده است. در این مقاله، مفهوم واقعیت توسعهیافته مقیاسپذیر (XRاس) یعنی فضاهایی که بین نمایشگرهای مختلف و درجات مجازی بودن که می توانند توسط کاربران متعدد و احتمالاً توزیع شده وارد شوند. توسعه چنین XRاسفضاها به چندین زمینه تحقیقاتی مربوط می شود. برای ارائه تعامل دوسویه و حفظ سازگاری با محیط واقعی، بازسازیهای مجازی صحنههای فیزیکی باید به صورت معنایی تقسیم شده و به صورت پویا تطبیق داده شوند. علاوه بر این، تکنیکهای تعامل مقیاسپذیر برای انتخاب، دستکاری، و ناوبری و همچنین ارائه تثبیتشده حاشیهنویسیهای دوبعدی در فضای سهبعدی مورد نیاز است تا به کاربران این امکان را بدهد که بهطور مستقیم بین نمایشگرهای دستی و روی سر جابجا شوند. تنظیمات مشارکتی باید کنترل دسترسی و نشانه های آگاهی را که مکان ها و اقدامات همکاران را نشان می دهد، ادغام کنند. در حالی که بسیاری از این موضوعات توسط تحقیقات قبلی مورد بررسی قرار گرفته بودند، تعداد بسیار کمی ادغام آنها را برای افزایش مقیاس پذیری در نظر گرفته اند. با پرداختن به این شکاف، تحقیقات قبلی مرتبط را مرور میکنیم و موانع فعلی توسعه XR را فهرست میکنیماسفضاها، و وابستگی های بین آنها را برجسته کنید.

1. معرفی

استفاده از انواع مختلف فناوریهای واقعیت توسعهیافته (XR) برای ورود به صحنههای واقعیت افزوده، مختلط یا واقعیت مجازی برای حوزههای مختلف کاربرد حمایتی در نظر گرفته شده است. به عنوان مثال، کاربران میتوانند اطلاعات متنی را بر حسب تقاضا در طول وظایف آموزشی یا تعمیر و نگهداری دریافت کنند، و فرآیندهای توسعه محصول میتوانند از تغییرات سریع و ارزان بهره ببرند، زیرا تقویتهای مجازی بر این اساس تطبیق داده میشوند. علاوه بر این، اتصال چند نمایشگر روی سر یا دستی در یک شبکه، پتانسیل زیادی برای فراهم کردن دسترسیهای سفارشیشده به یک فضای مشترک برای همکاران هممحل و همچنین توزیعشده دارد. با این حال، تا کنون اکثر برنامه های XR به موارد یکبار مصرف، فناوری خاص و دو کاربر محدود شده اند.

به دنبال کاهش این تلاش ها، مفهوم فضاهای XR مقیاس پذیر (XRاس) که به نظر ما برای کاربردهای مختلف مفید است. به عنوان مثال، توسعه محصول میتواند توسط سیستمهایی که از نمونههای اولیه مجازی به ترکیبی مقیاسبندی میشوند، و در نهایت محصولات فیزیکی با حاشیهنویسی منفرد، پشتیبانی شود. به طور مشابه، مجازی بودن می تواند با توجه به مهارت های ایجاد شده در سیستم های آموزشی یا پیشرفت در سایت های ساخت و ساز کاهش یابد. علاوه بر این، تیمهایی که در واقعیت افزوده یا ترکیبی کار میکنند، میتوانند توسط همکاران غایب که وارد بازسازی مجازی صحنه خود میشوند، ملحق شوند. بسته به وظایف و اولویتهای فردی، همکاران میتوانند از این طریق دارای نمایشگرهای روی سر یا دستی باشند.

در حالی که تحقیقات قبلی به طور جداگانه به سه موضوعی که ما برای توسعه XR حیاتی می دانیم پرداخته استاسفضاها (به عنوان مثال، ویژگیهای پشتیبانی از همکاری ، تجسمهای سازگار و در دسترس ، و تکنیکهای تعامل بصری )، ما بر روی یکپارچهسازی آنها برای افزایش مقیاسپذیری تمرکز میکنیم. برای این منظور، ما آخرین تحقیقات در زمینههای مرتبط را مرور میکنیم و یک دستور کار تحقیقاتی آینده را پیشنهاد میکنیم که هم موضوعات تحقیقاتی باقیمانده و هم تازهبافتاده را فهرست میکند.

2. پیشینه و اصطلاحات

2.1. واقعیت افزوده، ترکیبی و مجازی

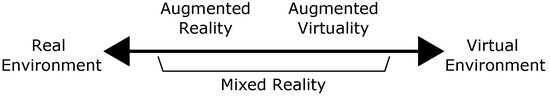

در سال 1994، میلگرام و کیشینو [ 1 ] طبقهبندی فناوریهایی را معرفی کردند که اجزای مجازی را با توجه به درجه مجازی بودن آنها یکپارچه میکند، که امروزه به نام پیوسته واقعیت-مجازی شناخته میشود [ 2 ]. برنامه های واقعیت مجازی ( VR ) در انتهای سمت راست زنجیره قرار دارند. در چنین محیط های کاملاً رایانه ای، کاربران سطوح بالایی از غوطه وری را تجربه می کنند. با حرکت در امتداد پیوسته به سمت چپ، درجه مجازی کاهش می یابد. همانطور که در شکل 1 نشان داده شده است، اصطلاح واقعیت ترکیبی ( MR ) هر دو تقویت صحنه های مجازی با محتوای واقعی را در بر می گیرد.مجازیسازی افزوده، AV ) و همچنین تقویت صحنههای واقعی با محتوای مجازی ( واقعیت افزوده، AR ). در حالی که پیوستار AR و AV را برابر نشان می دهد، میزان تحقیقاتی که پس از معرفی آن منتشر شده است به طور قابل توجهی برای AR بیشتر از AV است. این سهل انگاری AV در تفسیر کلی امروزی MR نیز منعکس شده است. در حال حاضر، MR با فضاهایی مرتبط است که اشیاء مجازی را در دنیای فیزیکی جاسازی میکنند (یعنی روی، جلو یا پشت سطوح دنیای واقعی)، در حالی که AR در عوض به صحنههای دنیای واقعی اشاره میکند که با پوششهای مجازی خالص تقویت شدهاند. از محدودیت های فیزیکی صحنه

شکل 1. پیوستار واقعیت-مجازیتی، با مجوز [ 2 ] بازتولید شده است.

در حالی که اکثر گوشیهای هوشمند و تبلتها میتوانند به عنوان نمایشگرهای دستی (HHD) برای ورود به فضاهای MR و VR استفاده شوند، کیفیت تجربه به شدت تحتتاثیر فناوری و حسگرهای گنجانده شده قرار میگیرد. به عنوان مثال، اسکنر LiDAR که در iPad Pro اپل [ 3 ] گنجانده شده است، اسکن صحنه را بهبود می بخشد و در نتیجه اشیاء مجازی را در دنیای واقعی جاسازی می کند. به غیر از HHD ها، کاربران ممکن است از نمایشگرهای نصب شده روی سر (HMD) استفاده کنند. برای دسترسی به صحنههای واقعیت مجازی، هدستهایی مانند HTC VIVE [ 4 ]، Oculus Rift، یا Oculus Quest [ 5 ] ممکن است استفاده شوند. HMD هایی که به کاربران اجازه ورود به صحنه های MR را می دهند عبارتند از Microsoft HoloLens [ 6 ]، Magic Leap [ 7 ] و Google Glass [ 8 ].]. علاوه بر این، انتظار میرود اپل در سالهای آینده یک HMD که بازی را تغییر میدهد منتشر کند [ 9 ]. در حالی که برخی از این فناوریها تعامل با تشخیص حرکت داخلی را فراهم میکنند، برخی دیگر از صفحهنمایشهای لمسی، کنترلکنندههای دستی خارجی یا فناوری ردیابی مانند کنترلکننده Leap Motion استفاده میکنند [ 10 ]. علاوه بر این، فناوری های مبتنی بر طرح ریزی مانند Powerwalls یا فضایی AR می توانند مورد استفاده قرار گیرند. در این مقاله، ما بر مقیاس پذیری بین HMD و HHD تمرکز می کنیم، به عنوان مثال، محیط هایی که می توان به صورت جداگانه با نمایشگرهای دو بعدی یا سه بعدی به آنها دسترسی داشت.

2.2. واقعیت توسعه یافته مقیاس پذیر (XRاس)

اخیراً، اصطلاح واقعیت توسعه یافته، و کمتر اوقات، واقعیت متقابل ( XR )، به طور فزاینده ای به عنوان یک اصطلاح چتر برای فناوری های مختلف واقع در امتداد زنجیره واقعیت-مجازی استفاده می شود [ 1 ، 2 ]. در این مقاله، ما از XR برای اشاره به کاربردهای AR، MR و VR به طور کلی استفاده میکنیم و HMD و HHD را توسط دستگاههای XR یا فناوریهای XR خلاصه میکنیم .

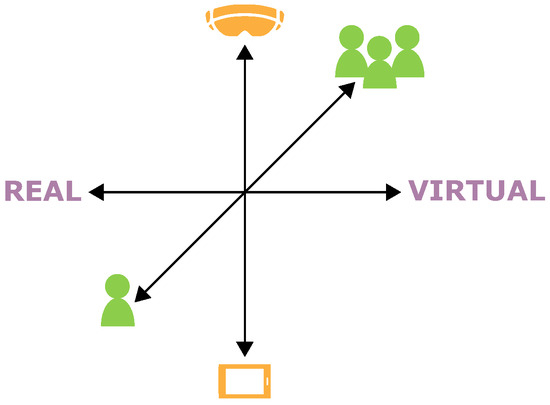

علاوه بر این، مفهوم واقعیت توسعهیافته مقیاسپذیر ( XRاس) توصیف فضاهایی که در امتداد سه بعد مختلف نشان داده شده در شکل 2 مقیاس می شوند : ■ از درجات کم تا زیاد مجازی (یعنی از سمت چپ به سمت راست زنجیره واقعیت-مجازی [ 1 ، 2 ]). ■ بین دستگاه های مختلف (یعنی HMD و HHD). و ■ از تک کاربر تا چند همکار که ممکن است در سایت های مختلف قرار داشته باشند. در ادامه از عبارت XR استفاده می کنیماسهرگاه به مفهوم این فضاهای بسیار مقیاس پذیر اشاره کنیم.

شکل 2. واقعیت توسعه یافته مقیاس پذیر (XRاس) فضاهایی که مقیاس پذیری را بین درجات مختلف مجازی بودن، ■ دستگاه ها و ■ تعداد همکاران فراهم می کند.

در حالی که برنامه های XR موجود بیشتر به موارد یکبار مصرف، فناوری خاص و دو کاربر، XR محدود می شونداسفضاها می توانند به عنوان محیط های آموزشی یا کاری انعطاف پذیر، طولانی مدت باشند. تکنیکهای تجسم و تعامل بسیار مقیاسپذیر میتوانند خاطرهانگیز بودن را افزایش دهند و به کاربران این امکان را میدهند که به طور مستقیم بین درجات مختلف مجازی بودن و دستگاهها جابجا شوند و در عین حال تمرکز خود را بر روی کار واقعی حفظ کنند. برای مثال، توسعه محصول میتواند توسط برنامههایی پشتیبانی شود که از نمونههای اولیه مجازی اولیه تا نمونههای اولیه فیزیکی که با محتویات مجازی منفرد تقویت میشوند، پشتیبانی میشوند، به عنوان مثال، درجه مجازی بودن با تکامل محصول کاهش مییابد. در این زمینه، زمان و هزینه ها را می توان کاهش داد زیرا اصلاح قطعات مجازی محصول سریعتر و ارزان تر از قطعات فیزیکی است. از آنجایی که فناوری های XR مختلف ممکن است برای درجات مختلف مجازی بودن و وظایف مختلف مناسب باشند، خاطرهانگیز بودن تکنیکهای تعامل باید تقویت شود تا کاربران از یادگیری مجدد تکنیکهای تعامل هر زمان که به دستگاه دیگری تغییر میکنند جلوگیری شود. با در نظر گرفتن چندین کاربر سیستم، به هر یک از همکاران میتوان اطلاعات مورد نیاز برای تکمیل کار را در صورت تقاضا از طریق افزایشهای سفارشیشده ارائه کرد و به XR ملحق شد.اسفضا در صحنه های MR یا VR با استفاده از HMD یا HHD بسته به ترجیحات فردی آنها و تنظیمات مشترک.

یوهانسن [ 11 ] سیستم های گروه افزاری را با توجه به زمان و مکان متمایز کرد. در این مقاله، ما عمدتاً بر روی همکاری همزمان تمرکز میکنیم، به عنوان مثال، همکاران در همان زمان در حال تعامل هستند اما میتوانند در یک مکان ( همکاری در محل ) یا سایتهای مختلف ( همکاری توزیعشده یا از راه دور ) قرار گیرند. در این زمینه، ما از اصطلاح همکار در محل برای هر کسی که در محیط کاری واقعی قرار دارد (مثلاً محل یک کارخانه واقعی یا نمونه فیزیکی) و از اصطلاح همکار خارج از محل برای هر کسی که از یک مکان دور به جلسه میپیوندد استفاده میکنیم. تحقیقات قبلی همچنین از این همکار خارج از سایت به عنوان یک متخصص از راه دور یاد می کند . در حالی که مدتremote به این معنی است که دو همکار در سایتهای مختلف قرار دارند، نشان نمیدهد کدام همکار در کدام سایت قرار دارد. با این حال، این اطلاعات در XR ارتباط بالایی دارداسفضاهایی که ممکن است فناوریهای مختلف برای همکاران در محل در صحنه MR (یعنی محیط کاری با تقویتهای مجازی) و همکاران خارج از سایت غوطهور در صحنه واقعیت مجازی (یعنی تکرار مجازی محیط کار از جمله تقویتها) استفاده شود. . از آنجایی که چنین XRاسفضاها می توانند نه تنها از همکاری مشترک، بلکه توزیع شده نیز پشتیبانی کنند، آنها پتانسیل قابل توجهی برای صرفه جویی در هزینه ها و زمان مربوط به سفر دارند.

3. به سوی واقعیت توسعه یافته مقیاس پذیر ( XRاس): موضوعات مرتبط و تحقیقات مرتبط

در حالی که XRاسفضاهایی که در بالا ذکر شد هنوز در دسترس نیستند، تحقیقات قبلی در زمینه های مختلف ممکن است به توسعه آنها کمک کند. بر اساس سه بعد (نگاه کنید به شکل 2 ) که در امتداد آن XRاسفضاها به منظور مقیاس بندی هستند، ما سه موضوع زیر را برای مرتبط بودن تعریف می کنیم: ساخت XRاسمقیاس فضاها ■ از تک کاربر تا چند همکار به ویژگی های پشتیبانی همکاری مناسب نیاز دارد. ارائه مقیاس پذیری بین درجات مختلف مجازی سازی مستلزم تجسم سازگار و قابل دسترس از تقویت مجازی و تکرار صحنه های فیزیکی است. و افزایش مقیاس پذیری بین فناوری های مختلف XR نیازمند طراحی تکنیک های تعامل به گونه ای است که به کاربران اجازه می دهد به طور مستقیم بین دستگاه ها جابجا شوند. به عنوان اولین قدم برای توسعه XRاس، این بخش یک نمای کلی از تحقیقات مرتبط در هر یک از این زمینه ها را ارائه می دهد و توضیح می دهد که در کجا نتایج تحقیقات قبلی برای ساخت XR یکپارچه شده است.اسفضاها چالش برانگیز است این بررسی به عنوان مبنایی برای تعیین دستور کار سؤالات باقی مانده و تازه مطرح شده که در بخش 4 ارائه شده است، عمل کرد .

3.1. ویژگی های پشتیبانی همکاری

بسته به پیکربندی XRاسفضا، همکاری می تواند بسیار متفاوت از همکاری حضوری و حضوری باشد. برای مثال، همکاران ممکن است نتوانند یکدیگر را ببینند یا بشنوند، که ممکن است مانع از تعامل طبیعی بین آنها شود. برای غلبه بر این موانع، تحقیقات قبلی چندین ویژگی را برای پشتیبانی از ارتباطات و هماهنگی در سناریوهای هممکانی [ 12 ، 13 ] یا توزیع شده [ 14 ، 15 ، 16 ، 17 ، 18 ، 19 ، 20 ، 21 ، 22 ] با استفاده از HHDs پیشنهاد کردند. 12 ، 13 ]، HMDs [ 14 ، 15 ، 16، 17 ، 18 ، 20 ، 21 ، 22 ] یا هر دو [ 19 ، 23 ].

چنین ویژگی های پشتیبانی همکاری شامل نشانه های آگاهی است که نشان می دهد همکاران کجا هستند یا چه می کنند. برای نشان دادن همکاران غایب در فضا، تحقیقات قبلی انواع مختلفی از آواتارها را در نظر گرفت: در حالی که برخی از آواتارهای شبیه انسان استفاده می کردند [ 18 ، 20 ، 21 ، 24 ]، برخی دیگر تنها بخش هایی از همکار را با استفاده از تکرارهای مجازی دستگاه XR مربوطه تجسم کردند [ 18 ، 19 ، 25 ]، frustums [ 14 ، 21 ، 25 ] یا اشیاء مجازی بیشتر را به عنوان بازنمایی انتزاعی مشاهده کنید [ 19 ، 22 ، 25]. در حالی که بیشتر آواتارها بر اساس حرکات دست و سر ساخته شده اند، برخی از رویکردها کل بدن را ردیابی می کنند. به عنوان مثال، یو و همکاران. [ 26 ] کاربران را بر اساس سایه آنها ردیابی کردند تا آواتار مربوطه را در زمان واقعی ایجاد کنند و Ahuja و همکاران. [ 27 ] وضعیتهای بدن را با ترکیب نماهای دوربینهای HHD چند کاربر در یک سناریوی همکم برآورد کرد. یک رویکرد ترکیبی از نمایشگرهای دو بعدی و سه بعدی توسط ایبایاشی و همکاران ارائه شد. [ 24]. همکاران میتوانند یک رابط روی میز را لمس کنند تا به مکانهای خاصی در یک فضای مجازی اشاره کنند، در حالی که همکار دیگری که با HMD وارد همان فضا میشود، میتواند دستهای مجازی بزرگی را که به سمت مکان مربوطه اشاره میکنند و همچنین چهره کاربران روی میز را که توسط دوربین گرفته شده است، ببیند. کاربر HMD در طرف دیگر میتوانست با لمس یک HHD که در جلوی HMD نصب شده است، به مکانهای خاصی اشاره کند و با یک آواتار نشان داده شود که جهت بازوها و سر بر این اساس تنظیم شده است. پیومسومبون و همکاران [ 20] توجه داشته باشید که آواتارهای مشارکت کنندگان در اندازه واقعی احتمالاً باعث انسداد می شوند و ممکن است از میدان دید فراتر رود. برای این منظور، آنها یک آواتار مینیاتوری پیشنهاد کردند که نشان دهنده همکار خارج از سایت است و جهت و ژست های نگاه مربوطه را تقلید می کند. مینیاتوری از آواتار در اندازه واقعی که نشان دهنده همکار خارج از سایت است، نگاه همکار در محل را دنبال می کند در حالی که یک نشانگر حلقه در پای مینیاتور مکان آواتار در اندازه واقعی را نشان می دهد [ 20 ]. در [ 21 ]، آواتار مینیاتوری که همکار خارج از سایت را نشان میدهد به میدان دید همکار در محل متصل نشده بود، اما میتوانست یک نشانه بصری (یعنی یک مشعل تقریباً در حال سوختن) برای جلب توجه همکار در محل اضافه کند. لی و همکاران [ 17] دریافت که تقویت نمای یک همکار با یک مستطیل، به تصویر کشیدن میدان دید فعلی همکار دیگر، هنگام استفاده از HMD با زوایای دید متفاوت ناموفق بود. بنابراین، اندازه مستطیل ها را با توجه به زاویه دید ارائه شده توسط دستگاه خروجی کاهش دادند. مشابه [ 14 ]، آنها ادغام فلش هایی را در نظر گرفتند که به سمت مکان همکار دیگر اشاره می کنند، زیرا در فضاهای سه بعدی بزرگ، همکاران ممکن است در پیدا کردن یکدیگر در زمانی که میدان های دید بسیار مخالف دارند، مشکل داشته باشند.

همکاری توزیع شده، به ویژه کمک از راه دور، به همکاران نیاز دارد که به اشیا یا مکانهای موجود در فضای مشترک اشاره کنند. یک رویکرد رایج برای نشان دادن جایی که کسی به آن اشاره می کند، نمایش پرتوهایی است که از چشم کاربر [ 14 ، 28 ] یا دست [ 13 ، 16 ، 20 ، 22 ، 23 ] منشا می گیرند. به جای رندر کردن کل پرتو، De Pace و همکاران. [ 18 ] فقط دایره ای را ارائه کرد که در آن اشعه و جسم با هم برخورد می کردند. پریرا و همکاران [ 19] همکاران و اشیاء را با فلش هایلایت می کرد و با رادارهای متحرک و دیوارهای شفاف از ناوبری به سمت اهداف خاص در فضا پشتیبانی می کرد. در مورد ادغام نشانهها برای حرکات دست، کارهای قبلی عمدتاً بر ردیابی دستهای همکار خارج از سایت متمرکز بود، زیرا دستهای همکار در محل اغلب در بازسازی فضای MR گرفته میشود. دوربینهای سهبعدی [ 15 ] و کنترلکننده Leap Motion [ 14 ، 16 ، 17 ] برای گرفتن حرکات دست همکار خارج از سایت و تقویت دید همکار در محل با مش بهدستآمده در زمان واقعی استفاده شدند. دیگران [ 19 ، 21 ، 22] حرکت کنترلرهای VR را برای ارائه یک نمایش انتزاعی از حرکات دست ردیابی کرد. در رویکرد ارائه شده توسط کیم و همکاران. [ 16 ]، همکار خارج از سایت میتواند حرکات مختلف دست را برای فعال کردن یک پرتو یا ترسیم طرحهای مجازی در محیط مشترک انجام دهد.

سناریوهای پیچیده تر، به ویژه آنهایی که اجازه دستکاری فعال توسط چندین همکار را می دهند، به کنترل دسترسی نیاز دارند . گراندی و همکاران [ 13 ] به همکارانی که با HHD ها تعامل دارند، اجازه می دهد تا به طور همزمان یک شی را با ضرب هر ماتریس تبدیل در یکی از شی مجازی دستکاری کنند. بنابراین، پرتوهای با رنگهای متفاوت نشان میدهند که کاربر کدام شی را انتخاب کرده و نمادها نشاندهنده دستکاری در حال انجام هستند. برعکس، ولز و هوبن [ 12 ] به تنها یکی از همکارانی که در محل قرار داشتند اجازه دادند تا در یک زمان یک شی را دستکاری کند. در طول دستکاری، شی مربوطه برای سایر کاربران قفل شد همانطور که با یک حاشیه رنگی در اطراف صفحه نمایش HHD نشان داده شد. پریرا و همکاران [ 19] یک مشتری اصلی در نظر گرفته می شود که قرار بود مالکیت را به مشتریان دیگر بدهد.

3.2. تجسم های سازگار و در دسترس

XRاسمقیاس بندی فضاها بین درجات مختلف مجازی بودن (یعنی از سمت چپ به سمت راست پیوستار واقعیت-مجازی [ 1 ، 2 ] و بالعکس)، امکان افزایش دیدگاه های همکاران در محل در صحنه های MR را فراهم می کند در حالی که خارج از سایت ارائه می شود. همکاران با بازسازی مجازی محیط در محل. برای حمایت از همکاری موثر، این بازسازی باید با محیط در سایت سازگار باشد (یعنی تغییرات در محیط فیزیکی باید در صحنه مجازی تطبیق داده شود) و قابل دسترسی باشد (یعنی همکاران خارج از سایت باید بتوانند به بخشهای خاصی اشاره کنند. در صحنه و تعامل با اشیاء مجازی).

تحقیقات قبلی رویکردهای مختلفی را دنبال کردند تا به همکاران خارج از سایت، بازسازی مجازی صحنههای فیزیکی را ارائه دهند. محیط در محل با استفاده از فناوریهایی مانند دوربینهای 360 درجه که تصاویر [ 22 ] یا فیلمها [ 17 ، 21 ، 22 ]، میدانهای نوری ساختهشده از تصاویر گرفتهشده با گوشی هوشمند [ 29 ]، چندگانه RGB-D [ 30 ] ارائه میکنند، گرفته شد. ] دوربینها، و همچنین نقشهبرداری فضایی داخلی [ 22 ، 31 ] برای ایجاد شبکهای از محیط. در حالی که برخی قبل از همکاری واقعی، محیط در محل را ضبط کردند [ 29 ، 31]، دیگران بازسازی آنلاین محیط در محل را ارائه کردند [ 17 ، 21 ، 30 ] که به صحنه مجازی اجازه میدهد مطابق با تغییرات در محل بهروزرسانی شود. صحنه های بازسازی شده را می توان از طریق VR-HMD [ 17 ، 19 ، 21 ، 22 ، 30 ، 31 ] یا HHD [ 29 ] مشاهده کرد.

برای پشتیبانی از همکاری در XRاسدر فضاها، همکاران خارج از سایت باید نمایش هایی از صحنه های فیزیکی ارائه دهند که کیفیت بصری بالا، به روز رسانی زنده، استقلال دیدگاه و دستکاری دو جهته را ارائه می دهند. با این حال، تحقیقات تا به امروز رویکردی را پیدا نکرده است که همه این معیارهای کیفیت را برآورده کند. در واقع، بررسی تحقیقات قبلی تفاوتهایی را بین کیفیت بصری و معیارهای کیفیت بیشتر نشان داد: در حالی که دوربینهای 360 درجه کیفیت بصری بالایی ارائه میدهند، آنها همچنین دیدگاه همکار خارج از سایت را با توجه به موقعیت دوربین محدود میکنند. برخلاف تصاویر 360 درجه ایستا، ویدئوهای 360 درجه نمایشی پویا از محیط در سایت را به همکار خارج از سایت ارائه می دهند.17 ، 21 ]. به این ترتیب، جهتگیری ویدیوی 360 درجه، همانطور که توسط لی و همکاران ذکر شد، همیشه به جهتگیری سر همکار در محل بستگی دارد. [ 17 ]. برای ارائه نمای مستقل به همکار خارج از سایت، جهت گیری سر همکار در محل را ردیابی کردند و نمای همکار خارج از سایت را بر این اساس تنظیم کردند. علاوه بر این، بازسازیهای مبتنی بر دوربینهای 360 درجه معمولاً از دستکاری دو طرفه جلوگیری میکنند، زیرا همکاران خارج از سایت میتوانند همه چیز را که در محل اتفاق میافتد ببینند اما خودشان نمیتوانند اشیاء مجازی را دستکاری کنند. در عوض، چندین نشانه بصری بهعنوان تقویتکنندههای مجازی ارائه شد تا به همکاران خارج از سایت اجازه دهد تا در طول اجرای کار به همکار در محل آموزش دهند [ 17 ، 21 ]]. از آنجایی که تصاویر 360 درجه ایستا تغییرات را در سایت ثبت نمی کنند، Teo et al. [ 22 ، 32 ] به همکاران خارج از سایت اجازه میدهد بین یک جریان ویدیویی 360 درجه برای تجسم پویا و با کیفیت بالا و یک شبکه سه بعدی استاتیک بافتدار با تصویر 360 درجه انتخاب کنند تا فضا را مستقل از همکار در محل کاوش کنند. . در [ 33 ]، آنها این سیستم را بیشتر توسعه دادند، به طوری که همکاران خارج از سایت می توانستند مش استاتیک را با تصاویر 360 درجه مختلف بازسازی کنند. با این حال، آنها دریافتند که این رویکرد احتمالاً سوراخ هایی را در صحنه مجازی در نقاطی ایجاد می کند که اشیاء در تصویر یکدیگر را مسدود می کنند.

بازسازی هندسی صحنههای فیزیکی بهدستآمده توسط دوربینهای عمق با هدف افزایش آگاهی فضایی همکار خارج از سایت از صحنه و امکان کاوش در فضا مستقل از مکان همکار در محل است. با این حال، ارائه بهروزرسانیهای زنده از تغییرات در محیط محل، چالش برانگیز است، زیرا تنها آن بخشهایی در فضا میتوانند بهروزرسانی شوند که توسط دوربین عمق در این لحظه خاص ثبت شوند. رویکردهایی که از حسگرهای گنجانده شده در هولولنز استفاده میکردند، بازسازی ایستا از صحنه قبل از همکاری واقعی را ثبت کردند [ 22 ، 31 ، 32 ، 33 ]. به عنوان مثال، تانایا و همکاران. [ 31] از یک شبکه به دست آمده با HoloToolkit Spatial Mapping برای ارائه بازسازی صحنه MR به کاربران VR-HMD استفاده کرد. با استفاده از این رویکرد، بهروزرسانیهای زنده به شدت به حرکات سر همکار در محل بستگی دارد و بنابراین احتمالاً به تأخیر میافتد. ارائه به روز رسانی زنده مستقل از موقعیت و جهت گیری کاربر، همانطور که توسط Lindlbauer و Wilson ارائه شده است [ 30]، به تنظیمات پیچیده تری نیاز دارد. آنها از هشت دوربین RGB-D برای ارائه یک بازسازی هندسی زنده از یک اتاق فیزیکی استفاده کردند که امکان تغییرات دقیق را توسط کاربر مانند پاک کردن، کپی کردن یا تغییر شکل اشیاء دنیای واقعی فراهم می کرد. دستکاری بلادرنگ با انجام فعل و انفعالات بر روی یک شبکه وکسل – یک نمایش حجمی از فضای بازسازی شده که در آن هر وکسل اطلاعاتی را در مورد دستکاریهای احتمالی نگه میدارد – فعال شد – که از نظر محاسباتی هزینه کمتری نسبت به انجام تعاملات روی شبکه زیرین داشت. موهر و همکاران [ 29]، با این حال، توجه داشته باشید که کیفیت بصری چنین رویکردهایی ممکن است توسط سطوح براق و شفاف که در محیطهای صنعتی رایج هستند – یک زمینه کاربردی اصلی برای فناوریهای XR – مختل شود. با پرداختن به این موضوع، آنها پیشنهاد کردند که یک میدان نوری از قسمت های مربوطه از فضای کاری به همکاران خارج از سایت ارائه شود. برای انجام این کار، همکار در محل از یک HHD برای گرفتن عکس هایی استفاده کرد که همراه با موقعیت و جهت HHD ذخیره شده بودند. به این ترتیب، همکار خارج از سایت می تواند حاشیه نویسی های سه بعدی را به میدان نوری تولید شده اضافه کند: تصویرسازی با کیفیت بالا و در عین حال ایستا از فضای کاری. در حالی که افزایش کیفیت بصری و دسترسی انتظار می رود همکاری را افزایش دهد، همچنین احتمالاً میزان داده هایی را که باید پردازش شوند افزایش می دهد. از سوی دیگر، این ممکن است باعث تاخیر شود، که می تواند ارتباط بین همکاران را مختل کند. از این رو، یکی دیگر از موضوعات مهم تحقیقاتی مربوط به بهینه سازی پردازش داده است. در این زمینه، استوتکو و همکاران. [34 ] چارچوبی برای به اشتراک گذاری صحنه های ایستا بازسازی شده بر اساس تصاویر RGB-D با چندین مشتری در زمان واقعی ارائه کرد. علاوه بر این، ممکن است با استفاده از دوقلوهای دیجیتال، مقدار دادههای پردازش شده به حداقل برسد. به این ترتیب، اشیاء دنیای واقعی که ظاهر خود را مطابق با مقادیر حسگر قابل دسترسی تغییر میدهند، نیازی به ردیابی و بازپرداخت مداوم ندارند. در عوض، مقادیر حسگر مربوطه را می توان به برنامه همکار خارج از سایت ارسال کرد که ظاهر مجازی شی را مطابق با وضعیت فعلی دوقلوی دیجیتالی آن ارائه می دهد. علاوه بر این، برخی از بخشهای محیط واقعی نه تنها توسط همکار در محل، بلکه توسط همکار خارج از سایت نیز قابل دستکاری است. به عنوان مثال، Jeršov و Tepljakov [ 35] سیستمی را ارائه کرد که امکان تغییر سطح آب یک سیستم فیزیکی چند مخزن را با دستکاری دوقلو دیجیتالی سیستم در یک محیط مجازی فراهم می کرد.

برای پشتیبانی از تعامل دو جهته در XRاس، همکاران خارج از سایت باید بتوانند به اشیاء موجود در فضای مشترک دسترسی داشته باشند و به آنها ارجاع دهند. در حالی که رویکرد ارائه شده توسط Lindlbauer و Wilson [ 30 ] به کاربران اجازه می دهد تا قسمت های خاصی را در فضای بازسازی شده دستکاری کنند، آنها تقسیم بندی معنایی را ارائه نکردند، به عنوان مثال، دستکاری ها بر روی اشیاء خاص انجام نشد بلکه روی مجموعه ای از وکسل های انتخاب شده توسط کاربر انجام شد. یک تقسیم بندی معنایی فضای بازسازی شده امکان ذخیره اطلاعات اضافی و همچنین رفتار دستکاری از پیش تعریف شده را در اشیاء تقسیم بندی شده معنایی می دهد و از این رو انتظار می رود انتخاب شی را تسریع کند و تعامل را تسهیل کند. شوت و همکاران [ 36] رویکردی را ارائه کرد که به شما امکان می دهد در حین استفاده از یک برنامه MR، فضاهای دنیای واقعی را به صورت معنایی تقسیم بندی کنید. آنها از شبکه ای از یک صحنه ثابت استفاده کردند که قبل از تقسیم بندی توسط هولولنز گرفته شده بود. با استفاده از برنامه واقعی MR، هولولنز تصاویر RGB را به یک برنامه سرور ارسال کرد که از یک روش موجود برای انجام تقسیم بندی معنایی پیروی می کرد. ابتدا، احتمالات کلاس به هر پیکسل اختصاص داده شد و متعاقباً مش با پیش بینی آن بر روی این احتمالات تقسیم شد. با اختصاص دادن هر رأس در مش به یک کلاس، اجزای متصل رئوس کلاس شی را می توان به عنوان اشیاء معنایی تفسیر کرد. سپس مش قطعهبندی شده معنایی به صحنه فیزیکی بازتاب داده شد، به طوری که اشیاء دنیای واقعی را میتوان برجسته کرد، و پس از انتخاب گزینههای دستکاری شی خاص را ارائه داد. حاشیه نویسی خودکار صحنه های سه بعدی می تواند از پیشرفت های اخیر در یادگیری عمیق سود بیشتری ببرد. با این حال، دای و همکاران. [37 ] اشاره کرد که در این زمینه داده های آموزشی برچسب گذاری شده وجود ندارد. برای رفع این مشکل، آنها سیستمی را ارائه کردند که به افراد تازه کار اجازه می داد از طریق اسکن RGB-D از صحنه های سه بعدی عکس بگیرند. مش های سه بعدی مربوطه به طور خودکار بازسازی شدند و می توانستند توسط کاربر حاشیه نویسی شوند. به این ترتیب، آنها توانستند مجموعه داده بزرگی از صحنه های سه بعدی برچسب زده شده را جمع آوری کنند. هوانگ و همکاران [ 38] از این مجموعه داده استفاده کرد و رویکردی را ارائه کرد که امکان بخش بندی معنایی فضای سه بعدی توصیف شده توسط سوپروکسل ها را در زمان واقعی فراهم می کرد. آنها خاطرنشان کردند که تا کنون، به کارگیری تکنیک های یادگیری عمیق به دلیل حجم زیاد داده هایی که صحنه های سه بعدی را توصیف می کنند، ناکارآمد بوده است. برای کاهش حجم دادههایی که باید پردازش شوند، آنها فقط وکسلهایی را در نظر گرفتند که سطوح را در محیط سهبعدی توصیف میکنند و خوشهبندی سوپروکسل روی سطح را اعمال کردند. با استفاده از یک شبکه عصبی کانولوشن، آنها توانستند یک تقسیم بندی معنایی را برای این سوپروکسل ها پیش بینی کنند.

همانطور که در بالا توضیح داده شد، XRاسمحیطها باید با HHD و همچنین HMD قابل دسترسی باشند. در حالی که هر دو فناوری را می توان برای کاوش یک صحنه سه بعدی استفاده کرد، لنگر انداختن حاشیه نویسی های دو بعدی در صحنه سه بعدی ساده نیست. به خصوص در تنظیمات مشترک، همکاران خارج از سایت ممکن است از HHD برای حاشیه نویسی محیط فیزیکی استفاده کنند. با این حال، همپوشانیهای مجازی ساده مانند حاشیهنویسیهایی که از نظر معنایی در فضا تثبیت نشدهاند، هر زمان که دیدگاه مشارکتکننده در سایت با دیدگاهی که حاشیهنویسی از آن اضافه شده متفاوت باشد، بیفایده خواهند شد. این موضوع در چندین مقاله تحقیقاتی [ 29 ، 39 ، 40 ، 41 ، 42 ، 43 ، 44 ] مورد توجه قرار گرفت. نورنبرگر و همکاران [43 ] راه پیشرفته ای برای لنگر انداختن طرح های دوبعدی دایره ها و فلش ها به روشی تثبیت شده جهانی پیشنهاد کرد. آنها از یک طبقهبندی حرکتی برای تفسیر نرمالهای طراحی و سطح صحنه کاربر استفاده کردند تا طرح مربوطه را در فضای سهبعدی ارائه دهند. رویکرد دیگری توسط Mohr و همکاران ارائه شد. [ 29 ]، که به همکار خارج از سایت اجازه می دهد تا میدان های نوری را در یک صفحه دو بعدی حاشیه نویسی کند، که پس از آن می توان با چرخش و ترجمه آن را به صحنه 3 بعدی تنظیم کرد. از آنجایی که دیدگاه همکار در سایت و خارج از سایت بر یک سیستم مختصات تکیه دارد، حاشیهنویسیها هنگام اشتراکگذاری بهعنوان تقویتکنندههای مجازی در میدان دید مشارکتکننده در سایت ظاهر میشوند. ارائه تثبیت شده جهانی از حاشیه نویسی های دوبعدی ارائه شده توسط Lien و همکاران. [ 44] بر اساس یک تکنیک تقسیم بندی تعاملی بود. فضای سه بعدی به عنوان یک نمودار متشکل از سه نوع راس که بیانگر حاشیه نویسی دو بعدی، نقاط صحنه سه بعدی و حجم های سه بعدی است، مدل سازی شد. برای بومی سازی شی هدف ارجاع شده، آنها روشی را برای برچسب گذاری این رئوس به عنوان بخشی از هدف یا پس زمینه آن پیشنهاد کردند. به این ترتیب، شی مورد نظر می تواند به روشی جهانی تثبیت شود.

3.3. تکنیک های تعامل شهودی

فناوریهای XR انواع تکنیکهای تعاملی را ارائه میکنند که از رابطهای لمسی و کنترلکنندههای خارجی گرفته تا ورودیهای مبتنی بر نگاه، گفتار یا ژستهای درون هوا را شامل میشود. با در نظر گرفتن یک برنامه کاربردی MR یا VR، تکنیک تعامل معمولاً با توجه به وظیفه خاص و محدودیت های ایجاد شده توسط فناوری انتخاب می شود. به عنوان مثال، HHD ها حداقل به یک دست برای نگه داشتن دستگاه نیاز دارند و VR-HMD معمولاً از دیدن بدن کاربران جلوگیری می کند. به این ترتیب، تکنیکهای تعامل مختلف ممکن است برای تکمیل کار با HMD یا HHD در برنامههای MR یا VR مناسبترین در نظر گرفته شوند. در مورد XRاسفضاها، یک معیار اضافی وارد عمل می شود: تکنیک تعامل باید بین HMD و HHD مقیاس شود، به عنوان مثال، این تکنیک باید برای کاربران بصری باقی بماند حتی زمانی که آنها دستگاه را تغییر می دهند. با این حال، تحقیقات قبلی عمدتاً به صورت جداگانه بر روی روشهای تعامل مختلف ارائه شده توسط فناوریهای XR از جمله در هوا متمرکز شده است [ 45 ، 46 ، 47 ، 48 ، 49 ، 50 ، 51 ، 52 ، 53 ، 54 ]، مبتنی بر لمس [ 55 ، 56 ] , 57 , 58 , 59 ], ملموس [ 60 ,61 ، 62 ]، تکنیک های ورودی مبتنی بر سر، نگاه، یا گفتار [ 45 ، 55 ، 58 ، 63 ، 64 ، 65 ] و چند وجهی [ 55 ، 58 ، 64 ] برای انتخاب و دستکاری اشیاء مجازی نیز برای حرکت در فضا بسیاری از این رویکردها نیازمند ردیابی بخشهایی از بدن کاربران یا دستگاههای تعامل خارجی هستند. در ادامه، تکنیکهای تعاملی را ارائه میکنیم که عمدتاً بر ردیابی نوری یا اینرسی تکیه دارند. ردیابی نوری، همانطور که فیکرت و همکاران اشاره کردند. [ 66]، تاخیر کم و نرخ به روز رسانی بالا را ارائه می دهد. آنها بین رویکردهای مبتنی بر نشانگر و بدون نشانگر تمایز قائل می شوند. در حالی که رویکردهای مبتنی بر نشانگر دقت بالایی ارائه میکنند، اما نسبت به روشهای بدون نشانگر مبتنی بر تکنیکهای بینایی کامپیوتری کمتر بصری در نظر گرفته میشوند. در زمینه XR، یک رویکرد رایج برای ردیابی نوری بدون نشانگر، گرفتن ورودی از طریق حرکات دست با کنترلر Leap Motion [ 25 ، 47 ، 50 ، 51 ] یا حسگرهای موجود در HoloLens [ 45 ، 46 ] بود. برای رویکردهای مبتنی بر نشانگر، نشانگرها به پاهای کاربر [ 53 ]، قسمت بالایی بدن [ 49 ] یا یک دستگاه خارجی [ 62 ] متصل میشدند.] بسته به روش ورودی. با این حال، یک نقطه ضعف عمده ردیابی نوری بدون نشانگر و مبتنی بر نشانگر مربوط به خط دید مستقیم مورد نیاز بین دوربین و شی هدف است. بسته به تنظیمات XR و موقعیت دوربین، این می تواند باعث ناراحتی و محدودیت حرکت کاربر شود. در این موارد، ردیابی اینرسی مفید در نظر گرفته می شود. کار قبلی (به عنوان مثال، [ 56 ، 58 ]) موقعیت و جهت گیری دستگاه های ورودی خارجی را در فضا با استفاده از حسگرهای IMU تعبیه شده در دستگاه – یک واحد اندازه گیری اینرسی که معمولاً از شتاب سنج ها، ژیروسکوپ ها و مغناطیس سنج ها تشکیل می شود- ردیابی کرد. چنین رویکردهایی تعامل را به بخش خاصی از فضا محدود نمی کند. با این حال، ممکن است برای حفظ دقت و تصحیح خطاهای دریفت، سنسورهای مربوطه بازنشانی شوند.66 ]. رویکردهای بیشتر (به عنوان مثال، [ 63 ، 64 ، 65 ]) از ردیاب های چشمی نصب شده روی سر برای ارائه ورودی از طریق تثبیت یا حرکات چشم استفاده کردند. یک نمای کلی از رویکردهای ردیابی چشم و تشخیص حرکت سر توسط [ 67 ] ارائه شده است.

انتخاب اشیاء مجازی یک کار کلیدی در فضاهای سه بعدی است زیرا برای برجسته کردن و دستکاری آیتم های مورد نظر عمل می کند. انتخاب معمولاً شامل دو مرحله است: (1) اشاره به هدف و (2) تأیید انتخاب. در ادامه با عبارت point به این مراحل فرعی اشاره کرده و تایید می کنیم. در حالی که برخی HMD ها مانند هولولنز با استفاده از یک دوربین تعبیه شده، تشخیص ژست های داخلی را ارائه می دهند، اکثر VR-HMD ها باید به سنسورهای اضافی مجهز شوند تا امکان انتخاب از طریق ژست های حرکتی در هوا وجود داشته باشد. به عنوان مثال، گارسیا-پریرا و همکاران. [ 25] کنترلر Leap Motion را به VR-HMD متصل کرد که دست کاربر را می گرفت و هنگام اشاره به یک هدف با یک پرتو آن را تقویت می کرد. با این حال، فناوری ردیابی نصب شده بر روی سر کاربر نیاز به بالا بردن بازوها به اندازه کافی برای گرفتن توسط حسگر دارد و بنابراین احتمالاً باعث خستگی می شود. روشهایی که حرکات درون هوا را از طریق دوربینهای خارجی ثبت میکنند، ردیابی را در موقعیتهای راحتتر فراهم میکنند، اما اغلب به تنظیمات پیچیدهای نیاز دارند و ممکن است تحرک کاربر را محدود کنند. به عنوان مثال، شویند و همکاران. [ 49 ] 18 نشانگر را به بازو و بدن کاربر متصل کرد که توسط 14 دوربین ردیابی شدند. به دنبال کاهش خستگی بازو با حفظ تحرک، تحقیقات قبلی چندین تکنیک انتخاب جایگزین را برای کاربران HMD پیشنهاد کرد. در این زمینه، Brasier و همکاران. [ 50] از کنترلر Leap Motion برای ایجاد یک صفحه مجازی در ناحیه کمر، ران یا مچ کاربر استفاده کرد که موقعیت ورودی راحت تری را برای حرکات دست در مقیاس کوچک برای کنترل مکان نما در MR ارائه می کرد. کاربران می توانند با حرکت دادن دست به موقعیت مربوطه در هواپیما مجازی به اهداف اشاره کنند. نگه داشتن مکان نما در نقطه مورد نظر انتخاب را تایید کرد. با استفاده از دستگاه IMU گنجانده شده، رو و همکاران. [ 56 ] به کاربرانی که MR-HMD پوشیده بودند، گوشی هوشمندی ارائه داد که به عنوان نشانگر لیزری برای اشاره به اهداف عمل می کرد. در همان زمان، رابط لمسی تلفن هوشمند به عنوان یک مدالیته ورودی برای دستکاری های بیشتر عمل کرد. به طور مشابه، چن و همکاران. [ 58] تعامل مبتنی بر IMU را با تلفن های هوشمند و ساعت های هوشمند که به عنوان نشانگر لیزری عمل می کنند مقایسه کرد. مکان نما از این طریق یا فقط توسط دستگاه هوشمند کنترل می شد (یعنی مکان نما می توانست میدان دید را ترک کند) یا در یک رویکرد ترکیبی که مکان نما همیشه در میدان دید باقی می ماند و حرکات در مقیاس بزرگ را می توان با حرکات سر انجام داد. حرکات در مقیاس کوچک در داخل میدان دید فعلی با دستگاه هوشمند. از طرف دیگر، مکان نما ثابت شده در مرکز میدان دید فقط با حرکات سر قابل کنترل است. سپس انتخاب ها را می توان با ضربه زدن روی رابط لمسی یا با چرخش مچ (ساعت هوشمند) تأیید کرد. به جای پارادایم نشانگر لیزری، آنها همچنین استفاده از سطح لمسی دستگاه هوشمند را به عنوان پد لمسی در نظر گرفتند. با این حال، نمایشگر ساعت هوشمند برای این رویکرد بسیار کوچک بود. یکی دیگر از تکنیکهای انتخاب مبتنی بر گوشیهای هوشمند برای کاربران MR-HMD توسط لی و همکاران پیشنهاد شد. [57 ]. حرکات مختلف لمسی (اجباری) برای هدایت مکان نما به نقطه شروع یک بخش متن استفاده شد. بخش متن بعد از نقطه شروع را می توان با انجام یک حرکت لمسی دایره ای یا با انتخاب نقطه پایان انتخاب کرد. علاوه بر انتخاب متن، این تکنیک ممکن است برای کارهای دیگر نیز کاربرد داشته باشد. بسانسون و همکاران [ 61 ] رویکردی برای انتخاب فضایی با HHD ترکیبی از لمس و ورودی ملموس ارائه کرد. کاربر شکلی را روی رابط لمسی ترسیم کرد که سپس با حرکت فیزیکی HHD برای انتخاب مجموعهای از نقاط داده سهبعدی، از فضای دادههای سه بعدی استفاده کرد. یکی دیگر از تکنیک های ورودی ملموس توسط واکر و همکاران پیشنهاد شد. [ 62]، که از یک خودکار پرینت سه بعدی با نشانگرهای بصری استفاده کرد که به کاربرانی که HHD در دست داشتند اجازه می داد اشیاء مجازی را انتخاب کنند. کرهها یا پرتوهای کوچک موقعیت قلم را نشان میدهند و میتوان از دکمهها برای تأیید انتخاب استفاده کرد. روشهای دیگری که میتوانند خستگی بازو را در حین انتخاب کاهش دهند به ورودی از طریق نگاه و پاها متکی هستند. همانطور که توسط مولر و همکاران پیشنهاد شده است. [ 53 ]، کاربرانی که از MR-HMD استفاده میکردند، میتوانستند با پای ردیابی نوری خود بر روی زمین ضربه بزنند تا آیتمهای یک رابط کاربری مجازی را انتخاب کنند که روی زمین یا در هوا پخش میشود. نوکارینن و همکاران [ 63] دو تکنیک مختلف انتخاب مبتنی بر نگاه را ارزیابی کرد که در آن شیء انتخاب شده از طریق نگاه متمرکز می شد و انتخاب با فشار دادن یک دکمه یا با ثابت نگه داشتن نگاه روی جسم برای مدت زمان مشخصی تأیید می شد. در حالی که این رویکرد به یک نوع ورودی نگاه محدود می شود، حسومی و هرتر [ 65 ] رویکردی را برای ورودی مبتنی بر نگاه کدهای عددی ارائه کردند (یعنی هر حرکت نگاه به یک رقم خاص نگاشت شد). برای انجام این کار، صفحهکلید عددی مجازی با نقاط کوچکی که بهطور مداوم شکل ارقام موجود را دنبال میکرد، افزوده شد، به طوری که با ثابت نگه داشتن چشمها بر روی نقطه متحرک مربوطه، میتوان اعداد را وارد کرد. یک رویکرد چند وجهی برای قفل کردن پیام ها به اشیاء دنیای واقعی توسط Bâce و همکاران ارائه شد. [ 64]. اشیاء دنیای واقعی بر اساس تثبیتهایی که توسط ردیابهای چشم شناسایی میشوند انتخاب میشوند و اطلاعاتی که قرار است در جسم ذخیره شوند از طریق لمس روی ساعت هوشمند انتخاب میشوند. از حرکات نگاه برای قفل و باز کردن اطلاعات مربوطه استفاده شد.

پس از انتخاب یک شی هدف، کاربران باید با تکنیک های مناسب برای دستکاری موقعیت، جهت و اندازه شی مجازی ارائه شوند . Chaconas و Höllerer [ 48 ] حرکات دو دست را برای انطباق جهت و اندازه اشیاء مجازی در حین پوشیدن MR-HMD ارزیابی کردند. برای انحراف، چرخاندن، به زمین انداختن و مقیاس اشیاء مجازی، کاربران باید دستهای نیشگونشده خود را نسبت به یکدیگر در جهتهای از پیش تعریفشده حرکت دهند. رویکردی با استفاده از حرکات یک دست برای گرفتن و حرکت دادن اشیاء مجازی با استفاده از گوشی های هوشمند توسط Botev و همکاران ارائه شد. [ 54 ]. رو و همکاران [ 56] از ورودی لمسی معمولی با گوشیهای هوشمند مانند ضربههای تکی و دوگانه، کشیدن انگشت و کشیدن با دو انگشت برای انتخاب و دستکاری بعدی استفاده میکرد. Fuvattanasilp و همکاران در مورد ورودی لمسی یک دست. [ 59] دشواری کنترل شش درجه آزادی (DoFs) با یک دست روی HHD را برجسته کرد. برای رسیدگی به این موضوع، آنها رویکردی را ارائه کردند که تعداد DoFهایی را که نیاز به کنترل یکباره دارند، کاهش داد. کاربر موقعیت 2 بعدی اولیه را از طریق ضربه زدن انتخاب کرد و سپس عمق را از طریق یک حرکت اسلاید در امتداد یک پرتو در HHD دستکاری کرد. سپس جهت گیری به طور خودکار با توجه به جهت گرانش (به دست آمده توسط IMU داخلی) تنظیم شد، به طوری که کاربر فقط باید با یک حرکت اسلاید روی HHD، شی را به دور این بردار جاذبه بچرخاند. تحقیقات بیشتر تکنیک های دستکاری ملموس را در نظر گرفت. به عنوان مثال، Bozgeyikli و Bozgeyikli [ 60] چرخش و ترجمه یک مکعب مجازی را با یک کنترلکننده خارجی، حرکات دست و تعامل ملموس (یعنی حرکت یک مکعب فیزیکی که توسط یک کنترلکننده قرار داده شده در داخل آن ردیابی شده بود) ارزیابی کرد. قلم AR-Pen ارائه شده توسط واکر و همکاران. [ 62 ] به کاربرانی که HHD را در دست دارند اجازه می دهد تا اشیاء مجازی را در صحنه سه بعدی حرکت دهند. پس از انتخاب شی مربوطه، می توان آن را با فشار دادن و رها کردن دکمه های روی قلم فیزیکی کشیده و رها کرد. به غیر از موقعیت و جهت هدف، کاربران ممکن است بخواهند اندازه آن را نیز دستکاری کنند. به عنوان مثال، بوسه و همکاران. [ 45] تکنیک های مختلف را برای بزرگنمایی در MR ارزیابی کرد. برای بزرگنمایی و کوچکنمایی، کاربرانی که HMD پوشیدهاند، میتوانند یک دست فشرده یا یک کنترلکننده خارجی را در امتداد یک محور خیالی حرکت دهند، دو دست فشرده را به سمت یکدیگر یا از یکدیگر دور کنند، یا از دستورات صوتی با استفاده از کلمات کلیدی کوچکتر یا بزرگتر استفاده کنند. در این زمینه، آنها خاطرنشان کردند که تحقیقات آینده باید بیشتر بررسی کند که چگونه ورودی گسسته (مانند ارائه شده توسط دستورات صوتی) بر تعامل تأثیر می گذارد. برای حاشیه نویسی اهداف در XRاس، کاربران باید اشیاء مجازی جدید را به فضا اضافه کنند. در این زمینه، چانگ و همکاران. [ 46 ] از کاربران MR-HMD خواست که فلش ها و دایره های مجازی را با دست های فشرده ترسیم کنند. حاشیهنویسیها یا در نوک انگشت ارائه میشوند یا در یک صفحه دوبعدی، که توسط تقاطع پرتوی منشأ گرفته از HMD و سطح دنیای واقعی تعیین میشود. علاوه بر این، Surale و همکاران. [ 47 ] تکنیک هایی را برای تغییر حالت، مانند تغییر رنگ ها در طول خط کشی سه بعدی در نظر گرفت. برای این منظور، آنها حرکات مختلف دست در هوا را که توسط یک کنترلر Leap Motion گرفته شده بود، ارزیابی کردند. کاربر VR-HMD یا ترسیم خط و تغییر حالت را با عقربه غالب انجام داد، یا از رویکرد دو دستی استفاده کرد که در آن هر عملیات با یک دست انجام میشد. مشابه [ 46]، خطوط سه بعدی با دست های نیشگون کشیده شد. تغییر حالت را می توان با چرخاندن مچ دست یا فشار دادن انگشت دیگر (رویکرد با یک دست)، و همچنین با بالا بردن دست غیر غالب، شکل دادن به یک مشت، کلیک کردن روی یک کنترلر یا لمس HMD (رویکرد دو دستی) برانگیخت. .

یک مزیت کلیدی محیط های صرفا مجازی مربوط به فضای موجود است که می تواند حتی اشیاء عظیم را در خود جای دهد. در حالی که VR به کاربران اجازه می دهد در فضاهای مجازی که می توانند بی نهایت بزرگ باشند غوطه ور شوند، اندازه اتاق فیزیکی که در واقع در آن واقع شده اند از نظر اندازه محدود است. بنابراین، تکنیک های ناوبری مناسب مورد نیاز است. در این زمینه، فون ویلیچ و همکاران. [ 52] پتانسیل تکنیک های ورودی مختلف را بر اساس موقعیت، فشار و جهت گیری پاهای کاربر برای حرکت در VR بررسی کرد. جهت حرکت یا با جهتی که پا به آن اشاره می کند، جهت نسبی بین دو پا، یا سمتی که کاربر به آن متمایل شده است (یعنی چپ یا راست، اندازه گیری شده با فشار) مشخص می شود. فاصله تا نقطه هدف یا با ارتفاعی که جلوی پا در آن بلند شده است، فاصله بین دو پا، یا قسمتی از پا که بیشترین فشار را دریافت می کند (یعنی انگشتان پا یا پاشنه برای فواصل کوچک یا بزرگ) مشخص می شود. استفاده از فضای موجود در VR، Biener et al. [ 55] چندین صفحه نمایش را در یک صحنه VR اختصاص می دهد که معمولاً با رایانه رومیزی قابل دسترسی هستند. آنها تبلتی را در اختیار کاربران VR-HMD قرار دادند که میتوان آن را شبیه به ترکپد برای پیمایش روی صفحه مجازی تنها با استفاده از یک انگشت و جابهجایی بین صفحههای مجازی مختلف با انجام حرکات دو دستی روی صفحه لمسی تبلت یا با نگاه کردن استفاده کرد. در صفحه نمایش خاص در حالی که تکنیکهای تعامل دو دستی در این مورد مفید تلقی میشوند، آنها برای تنظیماتی که حداقل یک دست برای نگه داشتن HHD لازم است، قابل اعمال نیستند. همچنین ساتریادی و همکاران. [ 51] دو تکنیک تعامل ترکیبی را برای ناوبری بر روی نقشه های افقی در مقیاس بزرگ با هدف کاهش حرکت دست (به عنوان مثال، خستگی بازو) و در عین حال حفظ تعامل دقیق در صورت نیاز معرفی کرد. آنها یک تکنیک تعاملی مبتنی بر استعاره جوی استیک را ترکیب کردند که در آن زوم و سرعت حرکت با جابجایی دست کاربر از موقعیت شروع با گرفتن غیرمستقیم، تکنیکی شهودیتر و دقیقتر و همچنین مستعد خستگی، به کاربران امکان میدهد تا حرکت کنند و با حرکت دادن دست ها در حالت نیشگون، بزرگنمایی کنید.

4. دستور کار تحقیقاتی آینده

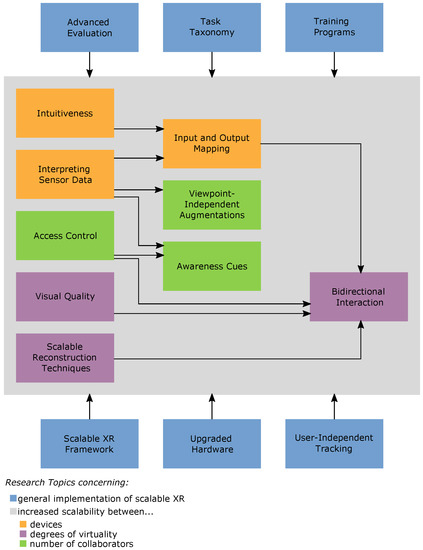

همانطور که در بالا خلاصه شد، تحقیقات قبلی بر تقویت ویژگیهای پشتیبانی همکاری، تجسم و تکنیکهای تعامل در زمینه تنظیمات XR متمرکز بود. با این حال، تحقیقات پیشرفته این موضوعات را جداگانه در نظر می گیرد و ادغام نتایج تحقیقات در هر یک از این زمینه ها را برای حمایت از همکاری در XR در نظر نمی گیرد.اسفضاها با پرداختن به این شکاف، یک دستور کار تحقیقاتی آینده را ارائه می کنیم که سؤالات تحقیقاتی باقی مانده و همچنین جدیداً مطرح شده را فهرست می کند. دستور کار پیشنهادی در موضوعات مربوط به اجرای کلی XR ساختار یافته استاسو موضوعاتی برای افزایش مقیاس پذیری بین ■ دستگاه های مختلف (یعنی HMD ها و HHD ها)، ■ درجات مختلف مجازی بودن (یعنی از چپ به سمت راست زنجیره واقعیت-مجازی [ 1 ، 2 ])، و ■ تعداد متفاوت همکارانی که ممکن است در سایت های مختلف قرار داشته باشند. مشارکت های مورد انتظار در میان این موضوعات تحقیقاتی جدید در شکل 3 نشان داده شده است.

شکل 3. موضوعات تحقیق مرتبط با توسعه XRاسفضاها و مشارکت های مورد انتظار در میان آنها.

4.1. موضوعات کلی تحقیق

■ XRاسچارچوب. از آنجایی که فناوریهای XR موجود توسط سازندگان مختلف ارائه میشوند و با سیستمعاملهای مختلف اجرا میشوند (مانند MR-HMD: HoloLens توسط Microsoft [ 6 ]، VR-HMD: VIVE توسط HTC [ 4 ]، و HHD: iPad Pro توسط Apple [ 3 ] ، همه آنها را به یک XR مشترک ترکیب می کنداسفضا نیاز به توسعه بین پلتفرمی دارد که به دلیل فقدان رابط های موجود مانع می شود. برای تسهیل توسعه چنین واسطهایی، تحقیقات آینده باید توسعه چارچوبی را در نظر بگیرد که تعاملات با اشیاء واقعی و مجازی را رسمیت میدهد و نوع دادههایی را که باید ردیابی و بین موجودیتها به اشتراک گذاشته شود، تشریح کند.

■ سخت افزار ارتقا یافته. برای اعمال XRاسدر عمل، سخت افزار ارتقا یافته ای مورد نیاز است که جنبه های ارگونومیکی را افزایش دهد و میدان دید بزرگ تری را فراهم کند. برخی از مطالعات (به عنوان مثال، [ 21 ، 51 ]) از VR-HMD برای انعکاس صحنه دنیای واقعی، از جمله تقویتهای مجازی استفاده کردند. در حالی که در حال حاضر VR-HMD های موجود زوایای دید بزرگ تری نسبت به MR-HMD ارائه می دهند، این رویکرد مانع از بهره گیری از مزایای واقعی فناوری های MR مانند کاهش انزوا و تعامل طبیعی با اشیاء دنیای واقعی می شود.

■ ردیابی مستقل از کاربر. در تحقیقات قبلی، سخت افزاری برای ردیابی قسمت هایی از بدن کاربر و همچنین ثبت صحنه در محل به کاربران متصل شده بود. یک رویکرد رایج برای گنجاندن حرکات دست به عنوان نشانه های آگاهی در فضای XR، اتصال کنترل کننده Leap Motion [ 10 ] به HMD همکار خارج از سایت بود. به این ترتیب، تقویت دید همکار در محل با دستان همکار خارج از سایت به شدت به حرکات دست و سر همکار خارج از سایت بستگی دارد. به طور مشابه، ردیابی صحنه فیزیکی با سخت افزار متصل به HMD همکاران در محل تحت تأثیر حرکات سر و موقعیت آنها قرار می گیرد. با توجه به پذیرش عملی XRاسفضاها، این وابستگی ها به رفتار انسان باید کاهش یابد.

■ ارزیابی پیشرفته. اکثر مقالات بررسی شده سیستم های مشارکتی را با دو شرکت کننده ارزیابی کردند. در حالی که برخی از جفتهای همکار قبل از آزمایش یکدیگر را میشناختند، دیگران هرگز قبلاً ملاقات نکرده بودند، و برخی از محققان (به عنوان مثال، [ 20 ، 21 )]) بازیگرانی را برای همکاری با همه شرکت کنندگان استخدام کرد. رویکرد دوم نتایج را قابل مقایسه تر می کند اما در عین حال انتقال به موارد استفاده واقعی را دشوارتر می کند. به این ترتیب، هنوز مشخص نیست که آیا سیستمی که از همکاری بین یک فرد آموزش دیده و یک فرد آموزش دیده پشتیبانی می کند، در صورت استفاده توسط دو همکار بدون آموزش نیز این کار را انجام دهد یا خیر. علاوه بر این، بسیاری از مطالعات به کارهای ساده و کوتاه مدت محدود شدند. از این رو، تحقیقات بیشتر باید ارزیابی با همکاران متعددی را که وظایف دنیای واقعی و بلندمدت را انجام می دهند، در نظر بگیرد.

■ Task Taxonomy. با توجه به تنوع تکنیکهای تجسم و تعامل ارائه شده در XR، این فناوریها در زمینههای مختلف برنامههای کاربردی پشتیبانی کننده تلقی میشوند. از آنجایی که هر زمینه از برنامه با نیازهای فردی همراه است، XR در حال توسعه و پیکربندی استاسفضاهای مربوط به موارد استفاده فردی را میتوان با طبقهبندی وظایف پشتیبانی کرد که توضیح میدهد کدام همکار باید چه اقداماتی را انجام دهد و نیاز به دسترسی به بخشهایی از فضای مشترک دارد. ایجاد طبقه بندی وظایف برای موارد استفاده فردی همچنین نشان می دهد که کدام وظایف در موارد استفاده چندگانه مرتبط هستند، به طوری که تلاش های تحقیقاتی آینده می تواند بر این اساس اولویت بندی شود.

■ برنامه های آموزشی. XRاسفضاها به عنوان محیط های کاری طولانی مدت بسیار منعطف هستند که به هر کاربر اجازه می دهد به راحتی بین فناوری های مختلف جابجا شود. از این رو، یک بار XRاسفضاها آماده به کارگیری در عمل هستند، روش های آموزشی مناسب برای موارد استفاده، فناوری ها و کاربران با سطوح مختلف تخصص مورد نیاز است.

4.2. مقیاس پذیری بین دستگاه های مختلف

■ شهودی. برای افزایش مقیاسپذیری بین HMD و HHD، باید تکنیکهای تجسم و تعاملی را در اختیار کاربران قرار داد که هنگام جابجایی بین این دستگاهها برای آنها بصری باقی بماند. برای این منظور، باید بررسی شود که کدام نوع نگاشت بین تکنیک های تعامل برای نمایشگرهای دو بعدی و سه بعدی بصری تلقی می شود. به ویژه، باید بررسی شود که آیا و چگونه شهودی بودن تحت تأثیر تجربیات قبلی و پارادایمهای تعامل شناخته شده و شناخته شده قرار میگیرد یا خیر. به عنوان مثال، برخی از تکنیک های تعامل مبتنی بر لمس توسط بسیاری از افرادی که از تلفن های هوشمند در زندگی روزمره خود استفاده می کنند، درونی می شوند. به این ترتیب، باید بررسی شود که آیا اصلاح این تکنیکهای تعامل، بهگونهای که از نظر عینی ممکن است شهودیتر به نظر برسد، به جای حمایت از آنها، آنها را گیج میکند یا خیر.

■ تفسیر داده های حسگر. به منظور پیادهسازی ویژگیهای پشتیبانی همکاری، تحقیقات قبلی از حسگرهای گنجانده شده در دستگاههای XR مانند جهتگیری HMD برای نمایش پرتوهای خیره استفاده کرد. در حالی که جهت HHD ها را می توان با حسگرهای تعبیه شده نیز بدست آورد، باید توجه داشت که جهت HHD همیشه با جهت نگاه واقعی کاربر مطابقت ندارد. از این رو، انتقال ویژگیهای پشتیبانی همکاری که برای یک دستگاه خاص اجرا میشود به یک دستگاه دیگر ساده نیست و میتواند باعث سوء تفاهم شود. برای جلوگیری از آنها، تحقیقات آینده باید بر نحوه تفسیر داده های موجود در زمینه موارد استفاده مختلف نیز تمرکز کند.

■ نگاشت ورودی و خروجی.نقشهبرداری ورودی و خروجی بین HMD و HHD باید بر اساس بینشهای تازه بهدستآمده در مورد شهودی بودن، تفسیر دادههای حسگر، و طبقهبندی وظایف ایجاد شده طراحی شود. بنابراین، روشهای ورودی موجود دستگاههای مختلف باید به گونهای مورد بهرهبرداری قرار گیرند که به کاربر اجازه دهد بهطور مستقیم اطلاعات را با HMD و HHD وارد کند. بدین ترتیب، طراحی نقشه خروجی باید اندازه های مختلف نمایش را در نظر بگیرد. همانطور که توسط چندین نویسنده اشاره شده است، استفاده از نمایشگرهای کوچک می تواند باعث انسداد زمانی که تقویت های مجازی بزرگ بر روی صفحه نمایش های کوچک رندر می شوند را ایجاد کند یا مانع از تشخیص تقویت های مجازی در زمانی که میدان دید محدود آنها ثبت نشده اند، شود. از این رو، باید بررسی شود که آیا و چگونه تقویتها را میتوان با اندازه نمایشگر تطبیق داد.

4.3. مقیاس پذیری بین درجات مختلف مجازی

■ کیفیت بصری. برای دستیابی به قابلیت استفاده بهینه، تحقیقات آینده باید بر روی مبادله بین کیفیت بصری و تأخیر تمرکز کنند. در این زمینه، باید بررسی شود که کدام بخش از یک صحنه فیزیکی در چه بازه های زمانی نیاز به بازسازی دارد. به عنوان مثال، در XR بزرگاسفضاها، بازسازی بلادرنگ ممکن است برای کل صحنه ضروری نباشد، بلکه فقط برای بخشهای خاص لازم باشد. به این ترتیب، کاهش حجم کلی داده های پردازش شده می تواند به بهبود کیفیت بصری مناطق خاص کمک کند.

■ تکنیک های بازسازی مقیاس پذیر. در بخش قبل، انواع تکنیک های موجود برای بازسازی صحنه های فیزیکی را همراه با مزایا و معایب فردی آنها ارائه کردیم. با توجه به پذیرش عملی این تکنیکها، صحنههای فیزیکی ممکن است با توجه به مواد سطح، شرایط رعد و برق و اندازه متفاوت باشند، به طوری که تکنیکهای بازسازی مختلف برای انواع مختلف محیطها مناسب هستند. برای تقویت مقیاس پذیری، تحقیقات بیشتر باید به توسعه تکنیک های بازسازی اختصاص داده شود که برای انواع صحنه های فیزیکی قابل استفاده است.

■ تعامل دو طرفه. تحقیقات قبلی به طور جداگانه بر بازسازی و تقسیم بندی معنایی صحنه های فیزیکی که ایستا یا پویا هستند متمرکز بود. به این ترتیب، تحقیقات آینده باید ادغام یافتههای موجود در این زمینههای تحقیقاتی مختلف را برای ارائه تجسمهای منسجم و قابل دسترس که امکان تعامل دو طرفه را فراهم میکند، در نظر بگیرد (یعنی هم مشارکتکنندگان در محل و هم خارج از سایت باید بتوانند به بخشهای خاصی اشاره و دستکاری کنند. در XRاسفضا).

4.4. مقیاس پذیری بین تعداد مختلف همکاران

■ کنترل دسترسی. ویژگیهای کنترل دسترسی پیادهسازیشده توسط تحقیقات قبلی شامل دستکاری همزمان از طریق ضرب ماتریسهای تبدیل و همچنین قفل کردن اشیا برای همه به جز یک همکار است. با توجه به افزایش تعداد همکاران، دستکاری همزمان می تواند منجر به جابجایی، چرخش یا ترجمه بیش از حد اشیا شود. در نتیجه، آنها باید به جلو و عقب دستکاری شوند، که می تواند به جای حمایت از همکاری، مانع از همکاری شود. از این رو، باید ارزیابی شود که دستکاری همزمان برای چه میزانی از همکاران امکان پذیر است و در چه مواردی باید مالکیت به همکاران مجرد داده شود.

■ تقویت های مستقل از دیدگاه. تعداد فزایندهای از همکاران، بهویژه در مکانهای مشترک، دیگر اجازه نخواهند داشت در کنار یکدیگر بایستند، زیرا کم و بیش همان دیدگاه XR را دارند.اسصحنه در عوض، آنها ممکن است در اطراف تقویتکنندههای مجازی در دایرههایی جمع شوند و با تقویتهای مجازی از دیدگاههای مختلف روبرو شوند. برای جلوگیری از سوء تفاهم و حفظ پشتیبانی همکاری، باید بررسی شود که چگونه تجسمها را میتوان به گونهای تنظیم کرد که به همکاران اجازه دهد از منظرهای مختلف به اشیاء مجازی دسترسی داشته باشند.

■ نشانه های آگاهی. تحقیقات قبلی انواع مختلفی از نشانههای آگاهی را پیشنهاد میکرد که نشان میداد همکاران چه میکنند یا کجا در فضا قرار دارند. با این حال، اکثر مطالعات کاربر بررسی شده به دو همکار محدود شده بود. با در نظر گرفتن تنظیماتی که شامل چندین همکار میشود، ارائه نشانههای آگاهی مانند پرتوهای نگاه برای همه همکاران بهطور همزمان احتمالاً باعث ایجاد درهمرفتگی بصری میشود که ممکن است بار شناختی را افزایش دهد. برای جلوگیری از اضافه بار شناختی و در عین حال حفظ عملکرد بهینه، به هر یک از همکاران باید آن دسته از نشانه های آگاهی ارائه شود که اطلاعات مورد نیاز برای تکمیل کار را ارائه می دهد. از آنجایی که وظایف و بار شناختی ممکن است به شدت در بین همکاران متفاوت باشد، ارائه دیدگاه های فردی برای هر همکار باید در نظر گرفته شود.

5. نتیجه گیری ها

در این مقاله به معرفی مفهوم XR می پردازیماسفضاهایی که بین درجات مختلف مجازی بودن، دستگاههای مختلف و تعداد متفاوت کاربران احتمالاً توزیع شده مقیاس میشوند. ما بر این باوریم که افزایش مقیاس پذیری پتانسیل زیادی برای افزایش پذیرش عملی فناوری های XR دارد، زیرا انتظار می رود چنین آموزش های طولانی مدت یا محیط های کاری بسیار انعطاف پذیر باعث کاهش هزینه ها و افزایش خاطره انگیزی شود. با این حال، توسعه چنین برنامه هایی ساده نیست و شامل تحقیقات بین رشته ای است. در واقع، ما موضوعات زیر را مرتبط ترین زمینه های تحقیقاتی برای توسعه XR در نظر می گیریماسفضاها: (1) ویژگیهای پشتیبانی از همکاری مانند کنترل دسترسی، و همچنین نشانههای آگاهی که نشان میدهد سایر همکاران کجا هستند و چه میکنند. (2) تجسمهای سازگار و در دسترس که شامل تقسیمبندی معنایی صحنههای فیزیکی تقریباً بازسازیشده است. (3) تکنیک های تعامل برای انتخاب، دستکاری، و ناوبری در XRاسکه حتی زمانی که کاربران بین دستگاهها یا درجاتی از مجازی بودن سوئیچ میکنند، برای کاربران شهودی باقی میمانند.

در حالی که تاکنون این موضوعات به طور جداگانه بررسی شده اند، ما پیشنهاد می کنیم که نتایج کارهای قبلی را برای افزایش مقیاس پذیری ادغام کنیم. در حال توسعه XRاسفضاها به چندین زمینه تحقیقاتی مستقل مرتبط است که مدت ها قبل از ظهور فناوری های XR وجود داشته است. در این مقاله، ما بر روی جدیدترین مقالات تحقیقاتی در این زمینهها که با کاربردهای AR، MR یا VR سروکار دارند، تمرکز میکنیم. بنابراین، به عنوان اولین گام برای ساخت XRاسما کار مرتبط را مرور می کنیم و چالش های ناشی از ادغام نتایج تحقیقات قبلی را برجسته می کنیم. بر این اساس، ما دستور کار سوالات بسیار مرتبط را پیشنهاد می کنیم که باید توسط تحقیقات آینده به منظور ساخت XR مورد توجه قرار گیرد.اسفضاهایی که به طور کامل از پتانسیل ذاتی فناوری های XR استفاده می کنند.

References

- Milgram, P.; Kishino, F. A Taxonomy of Mixed Reality Visual Displays. IEICE Trans. Inf. Syst. 1994, 77, 1321–1329. [Google Scholar]

- Milgram, P.; Takemura, H.; Utsumi, A.; Kishino, F. Augmented Reality: A class of displays on the reality-virtuality continuum. In Telemanipulator and Telepresence Technologies; Das, H., Ed.; SPIE: Bellingham, WA, USA, 1995; Volume 2351, pp. 282–292. [Google Scholar] [CrossRef]

- iPad Pro. Available online: https://www.apple.com/ipad-pro/ (accessed on 28 October 2021).

- VIVE Pro Series. Available online: https://www.vive.com/us/product/#pro%20series (accessed on 28 October 2021).

- Oculus Headsets. Available online: https://www.oculus.com/compare/ (accessed on 17 January 2022).

- HoloLens 2. Available online: https://www.microsoft.com/en-us/hololens/hardware (accessed on 28 October 2021).

- Magic Leap. Available online: https://www.magicleap.com/en-us/magic-leap-1 (accessed on 17 January 2022).

- Glass. Available online: https://www.google.com/glass/tech-specs/ (accessed on 17 January 2022).

- Perry, T.S. Look Out for Apple’s AR Glasses: With head-up displays, cameras, inertial sensors, and lidar on board, Apple’s augmented-reality glasses could redefine wearables. IEEE Spectr. 2021, 58, 26–54. [Google Scholar] [CrossRef]

- Leap Motion Controller. Available online: https://www.ultraleap.com/product/leap-motion-controller/ (accessed on 28 October 2021).

- Johansen, R. Teams for tomorrow (groupware). In Proceedings of the Twenty-Fourth Annual Hawaii International Conference on System Sciences, Kauai, HI, USA, 8–11 January 1991; IEEE: Piscataway, NJ, USA, 1991; Volume 3, pp. 521–534. [Google Scholar] [CrossRef]

- Wells, T.; Houben, S. CollabAR—Investigating the Mediating Role of Mobile AR Interfaces on Co-Located Group Collaboration. In Proceedings of the 2020 CHI Conference on Human Factors in Computing Systems, Honolulu, HI, USA, 25–30 April 2020; ACM: New York, NY, USA, 2020. [Google Scholar] [CrossRef]

- Grandi, J.G.; Debarba, H.G.; Bemdt, I.; Nedel, L.; Maciel, A. Design and Assessment of a Collaborative 3D Interaction Technique for Handheld Augmented Reality. In Proceedings of the 2018 IEEE Conference on Virtual Reality and 3D User Interfaces (VR), Tuebingen/Reutlingen, Germany, 18–22 March 2018; IEEE: Piscataway, NJ, USA, 2018; pp. 49–56. [Google Scholar] [CrossRef]

- Bai, H.; Sasikumar, P.; Yang, J.; Billinghurst, M. A User Study on Mixed Reality Remote Collaboration with Eye Gaze and Hand Gesture Sharing. In Proceedings of the 2020 CHI Conference on Human Factors in Computing Systems, Honolulu, HI, USA, 25–30 April 2020; ACM: New York, NY, USA, 2020. [Google Scholar] [CrossRef]

- Huang, W.; Alem, L.; Tecchia, F.; Duh, H.B.L. Augmented 3D hands: A gesture-based mixed reality system for distributed collaboration. J. Multimodal User Interfaces 2018, 12, 77–89. [Google Scholar] [CrossRef]

- Kim, S.; Lee, G.; Huang, W.; Kim, H.; Woo, W.; Billinghurst, M. Evaluating the Combination of Visual Communication Cues for HMD-based Mixed Reality Remote Collaboration. In Proceedings of the 2019 CHI Conference on Human Factors in Computing Systems, Glasgow, UK, 4–9 May 2019; ACM: New York, NY, USA, 2019. [Google Scholar] [CrossRef]

- Lee, G.A.; Teo, T.; Kim, S.; Billinghurst, M. A User Study on MR Remote Collaboration Using Live 360 Video. In Proceedings of the 2018 IEEE International Symposium on Mixed and Augmented Reality (ISMAR), Munich, Germany, 16–20 October 2018; IEEE: Piscataway, NJ, USA, 2018; pp. 153–164. [Google Scholar] [CrossRef]

- De Pace, F.; Manuri, F.; Sanna, A.; Zappia, D. A Comparison between Two Different Approaches for a Collaborative Mixed-Virtual Environment in Industrial Maintenance. Front. Robot. AI 2019, 6, 18. [Google Scholar] [CrossRef] [PubMed]

- Pereira, V.; Matos, T.; Rodrigues, R.; Nóbrega, R.; Jacob, J. Extended Reality Framework for Remote Collaborative Interactions in Virtual Environments. In Proceedings of the 2019 International Conference on Graphics and Interaction (ICGI), Faro, Portugal, 21–22 November 2019; IEEE: Piscataway, NJ, USA, 2019; pp. 17–24. [Google Scholar] [CrossRef]

- Piumsomboon, T.; Lee, G.A.; Hart, J.D.; Ens, B.; Lindeman, R.W.; Thomas, B.H.; Billinghurst, M. Mini-Me: An Adaptive Avatar for Mixed Reality Remote Collaboration. In Proceedings of the 2018 CHI Conference on Human Factors in Computing Systems, Montreal, QC, Canada, 21–26 April 2018; ACM: New York, NY, USA, 2018. [Google Scholar] [CrossRef]

- Piumsomboon, T.; Lee, G.A.; Irlitti, A.; Ens, B.; Thomas, B.H.; Billinghurst, M. On the Shoulder of the Giant: A Multi-Scale Mixed Reality Collaboration with 360 Video Sharing and Tangible Interaction. In Proceedings of the 2019 CHI Conference on Human Factors in Computing Systems, Glasgow, UK, 4–9 May 2019; ACM: New York, NY, USA, 2019. [Google Scholar] [CrossRef]

- Teo, T.; Hayati, A.F.; Lee, G.A.; Billinghurst, M.; Adcock, M. A Technique for Mixed Reality Remote Collaboration using 360 Panoramas in 3D Reconstructed Scenes. In Proceedings of the 25th ACM Symposium on Virtual Reality Software and Technology, Parramatta, NSW, Australia, 12–15 November 2019; ACM: New York, NY, USA, 2019. [Google Scholar] [CrossRef]

- Marks, S.; White, D. Multi-Device Collaboration in Virtual Environments. In Proceedings of the 2020 4th International Conference on Virtual and Augmented Reality Simulations, Sydney, NSW, Australia, 14–16 February 2020; ACM: New York, NY, USA, 2020; pp. 35–38. [Google Scholar] [CrossRef]

- Ibayashi, H.; Sugiura, Y.; Sakamoto, D.; Miyata, N.; Tada, M.; Okuma, T.; Kurata, T.; Mochimaru, M.; Igarashi, T. Dollhouse VR: A Multi-View, Multi-User Collaborative Design Workspace with VR Technology. In Proceedings of the SIGGRAPH Asia 2015 Emerging Technologies, Kobe, Japan, 2–6 November 2015; ACM: New York, NY, USA, 2015. [Google Scholar] [CrossRef]

- García-Pereira, I.; Gimeno, J.; Pérez, M.; Portalés, C.; Casas, S. MIME: A Mixed-Space Collaborative System with Three Immersion Levels and Multiple Users. In Proceedings of the 2018 IEEE International Symposium on Mixed and Augmented Reality Adjunct (ISMAR-Adjunct), Munich, Germany, 16–20 October 2018; IEEE: Piscataway, NJ, USA, 2018; pp. 179–183. [Google Scholar] [CrossRef]

- Yu, D.; Jiang, W.; Wang, C.; Dingler, T.; Velloso, E.; Goncalves, J. ShadowDancXR: Body Gesture Digitization for Low-cost Extended Reality (XR) Headsets. In Proceedings of the Companion, 2020 Conference on Interactive Surfaces and Spaces, Virtual Event, Portugal, 8–11 November 2020; ACM: New York, NY, USA, 2020; pp. 79–80. [Google Scholar] [CrossRef]

- Ahuja, K.; Goel, M.; Harrison, C. BodySLAM: Opportunistic User Digitization in Multi-User AR/VR Experiences. In Proceedings of the Symposium on Spatial User Interaction, Virtual Event, Canada, 30 October–1 November 2020; ACM: New York, NY, USA, 2020. [Google Scholar] [CrossRef]

- Erickson, A.; Norouzi, N.; Kim, K.; Schubert, R.; Jules, J.; LaViola, J.J., Jr.; Bruder, G.; Welch, G.F. Sharing gaze rays for visual target identification tasks in collaborative augmented reality. J. Multimodal User Interfaces 2020, 14, 353–371. [Google Scholar] [CrossRef]

- Mohr, P.; Mori, S.; Langlotz, T.; Thomas, B.H.; Schmalstieg, D.; Kalkofen, D. Mixed Reality Light Fields for Interactive Remote Assistance. In Proceedings of the 2020 CHI Conference on Human Factors in Computing Systems, Honolulu, HI, USA, 25–30 April 2020; ACM: New York, NY, USA, 2020. [Google Scholar] [CrossRef]

- Lindlbauer, D.; Wilson, A.D. Remixed Reality: Manipulating Space and Time in Augmented Reality. In Proceedings of the 2018 CHI Conference on Human Factors in Computing Systems, Montreal, QC, Canada, 21–26 April 2018; ACM: New York, NY, USA, 2018. [Google Scholar] [CrossRef]

- Tanaya, M.; Yang, K.; Christensen, T.; Li, S.; O’Keefe, M.; Fridley, J.; Sung, K. A Framework for analyzing AR/VR Collaborations: An initial result. In Proceedings of the 2017 IEEE International Conference on Computational Intelligence and Virtual Environments for Measurement Systems and Applications (CIVEMSA), Annecy, France, 26–28 June 2017; IEEE: Piscataway, NJ, USA, 2017; pp. 111–116. [Google Scholar] [CrossRef]

- Teo, T.; Lawrence, L.; Lee, G.A.; Billinghurst, M.; Adcock, M. Mixed Reality Remote Collaboration Combining 360 Video and 3D Reconstruction. In Proceedings of the 2019 CHI Conference on Human Factors in Computing Systems, Glasgow, UK, 4–9 May 2019; ACM: New York, NY, USA, 2019. [Google Scholar] [CrossRef]

- Teo, T.; Norman, M.; Lee, G.A.; Billinghurst, M.; Adcock, M. Exploring interaction techniques for 360 panoramas inside a 3D reconstructed scene for mixed reality remote collaboration. J. Multimodal User Interfaces 2020, 14, 373–385. [Google Scholar] [CrossRef]

- Stotko, P.; Krumpen, S.; Hullin, M.B.; Weinmann, M.; Klein, R. SLAMCast: Large-Scale, Real-Time 3D Reconstruction and Streaming for Immersive Multi-Client Live Telepresence. IEEE Trans. Vis. Comput. Graph. 2019, 25, 2102–2112. [Google Scholar] [CrossRef] [PubMed]

- Jeršov, S.; Tepljakov, A. Digital Twins in Extended Reality for Control System Applications. In Proceedings of the 2020 43rd International Conference on Telecommunications and Signal Processing (TSP), Milan, Italy, 7–9 July 2020; IEEE: Piscataway, NJ, USA, 2020; pp. 274–279. [Google Scholar] [CrossRef]

- Schütt, P.; Schwarz, M.; Behnke, S. Semantic Interaction in Augmented Reality Environments for Microsoft HoloLens. In Proceedings of the 2019 European Conference on Mobile Robots (ECMR), Prague, Czech Republic, 4–6 September 2019; IEEE: Piscataway, NJ, USA, 2019. [Google Scholar] [CrossRef]

- Dai, A.; Chang, A.X.; Savva, M.; Halber, M.; Funkhouser, T.; Nießner, M. ScanNet: Richly-Annotated 3D Reconstructions of Indoor Scenes. In Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Honolulu, HI, USA, 21–26 July 2017; IEEE: Piscataway, NJ, USA, 2017; pp. 2432–2443. [Google Scholar] [CrossRef]

- Huang, S.S.; Ma, Z.Y.; Mu, T.J.; Fu, H.; Hu, S.M. Supervoxel Convolution for Online 3D Semantic Segmentation. ACM Trans. Graph. 2021, 40, 1–15. [Google Scholar] [CrossRef]

- Gauglitz, S.; Lee, C.; Turk, M.; Höllerer, T. Integrating the physical environment into mobile remote collaboration. In Proceedings of the 14th International Conference on Human-Computer Interaction with Mobile Devices and Services, San Francisco, CA, USA, 21–24 September 2012; ACM: New York, NY, USA, 2012; pp. 241–250. [Google Scholar] [CrossRef]

- Gauglitz, S.; Nuernberger, B.; Turk, M.; Höllerer, T. In Touch with the Remote World: Remote Collaboration with Augmented Reality Drawings and Virtual Navigation. In Proceedings of the 20th ACM Symposium on Virtual Reality Software and Technology, Edinburgh, UK, 11–13 November 2014; ACM: New York, NY, USA, 2014; pp. 197–205. [Google Scholar] [CrossRef]

- Gauglitz, S.; Nuernberger, B.; Turk, M.; Höllerer, T. World-stabilized annotations and virtual scene navigation for remote collaboration. In Proceedings of the 27th Annual ACM Symposium on User Interface Software and Technology, Honolulu, HI, USA, 5–8 October 2014; ACM: New York, NY, USA, 2014; pp. 449–459. [Google Scholar] [CrossRef]

- Nuernberger, B.; Lien, K.C.; Grinta, L.; Sweeney, C.; Turk, M.; Höllerer, T. Multi-view gesture annotations in image-based 3D reconstructed scenes. In Proceedings of the 22nd ACM Conference on Virtual Reality Software and Technology, Munich, Germany, 2–4 November 2016; ACM: New York, NY, USA, 2016; pp. 129–138. [Google Scholar] [CrossRef]

- Nuernberger, B.; Lien, K.C.; Höllerer, T.; Turk, M. Interpreting 2D gesture annotations in 3D augmented reality. In Proceedings of the 2016 IEEE Symposium on 3D User Interfaces (3DUI), Greenville, SC, USA, 19–20 March 2016; IEEE: Piscataway, NJ, USA, 2016; pp. 149–158. [Google Scholar] [CrossRef]

- Lien, K.C.; Nuernberger, B.; Höllerer, T.; Turk, M. PPV: Pixel-Point-Volume Segmentation for Object Referencing in Collaborative Augmented Reality. In Proceedings of the 2016 IEEE International Symposium on Mixed and Augmented Reality (ISMAR), Merida, Mexico, 19–23 September 2016; IEEE: Piscataway, NJ, USA, 2016; pp. 77–83. [Google Scholar] [CrossRef]

- Kiss, F.; Woźniak, P.W.; Biener, V.; Knierim, P.; Schmidt, A. VUM: Understanding Requirements for a Virtual Ubiquitous Microscope. In Proceedings of the 19th International Conference on Mobile and Ubiquitous Multimedia, Essen, Germany, 22–25 November 2020; ACM: New York, NY, USA, 2020; pp. 259–266. [Google Scholar] [CrossRef]

- Chang, Y.S.; Nuernberger, B.; Luan, B.; Höllerer, T. Evaluating gesture-based augmented reality annotation. In Proceedings of the 2017 IEEE Symposium on 3D User Interfaces (3DUI), Los Angeles, CA, USA, 18–19 March 2017; IEEE: Piscataway, NJ, USA, 2017; pp. 182–185. [Google Scholar] [CrossRef]

- Surale, H.B.; Matulic, F.; Vogel, D. Experimental Analysis of Barehand Mid-air Mode-Switching Techniques in Virtual Reality. In Proceedings of the 2019 CHI Conference on Human Factors in Computing Systems, Glasgow, UK, 4–9 May 2019; ACM: New York, NY, USA, 2019. [Google Scholar] [CrossRef]

- Chaconas, N.; Höllerer, T. An Evaluation of Bimanual Gestures on the Microsoft HoloLens. In Proceedings of the 2018 IEEE Conference on Virtual Reality and 3D User Interfaces (VR), Tuebingen/Reutlingen, Germany, 18–22 March 2018; IEEE: Piscataway, NJ, USA, 2018. [Google Scholar] [CrossRef]

- Schwind, V.; Mayer, S.; Comeau-Vermeersch, A.; Schweigert, R.; Henze, N. Up to the Finger Tip: The Effect of Avatars on Mid-Air Pointing Accuracy in Virtual Reality. In Proceedings of the 2018 Annual Symposium on Computer-Human Interaction in Play, Melbourne, VIC, Australia, 28–31 October 2018; ACM: New York, NY, USA, 2018; pp. 477–488. [Google Scholar] [CrossRef]

- Brasier, E.; Chapuis, O.; Ferey, N.; Vezien, J.; Appert, C. ARPads: Mid-air Indirect Input for Augmented Reality. In Proceedings of the 2020 IEEE International Symposium on Mixed and Augmented Reality (ISMAR), Porto de Galinhas, Brazil, 9–13 November 2020; IEEE: Piscataway, NJ, USA, 2020; pp. 332–343. [Google Scholar] [CrossRef]

- Satriadi, K.A.; Ens, B.; Cordeil, M.; Jenny, B.; Czauderna, T.; Willett, W. Augmented Reality Map Navigation with Freehand Gestures. In Proceedings of the 2019 IEEE Conference on Virtual Reality and 3D User Interfaces (VR), Osaka, Japan, 23–27 March 2019; IEEE: Piscataway, NJ, USA, 2019; pp. 593–603. [Google Scholar] [CrossRef]

- von Willich, J.; Schmitz, M.; Müller, F.; Schmitt, D.; Mühlhäuser, M. Podoportation: Foot-Based Locomotion in Virtual Reality. In Proceedings of the 2020 CHI Conference on Human Factors in Computing Systems, Honolulu, HI, USA, 25–30 April 2020; ACM: New York, NY, USA, 2020. [Google Scholar] [CrossRef]

- Müller, F.; McManus, J.; Günther, S.; Schmitz, M.; Mühlhäuser, M.; Funk, M. Mind the Tap: Assessing Foot-Taps for Interacting with Head-Mounted Displays. In Proceedings of the 2019 CHI Conference on Human Factors in Computing Systems, Glasgow, UK, 4–9 May 2019; ACM: New York, NY, USA, 2019. [Google Scholar] [CrossRef]

- Botev, J.; Mayer, J.; Rothkugel, S. Immersive mixed reality object interaction for collaborative context-aware mobile training and exploration. In Proceedings of the 11th ACM Workshop on Immersive Mixed and Virtual Environment Systems, Amherst, MA, USA, 18 June 2019; ACM: New York, NY, USA, 2019; pp. 4–9. [Google Scholar] [CrossRef]

- Biener, V.; Schneider, D.; Gesslein, T.; Otte, A.; Kuth, B.; Kristensson, P.O.; Ofek, E.; Pahud, M.; Grubert, J. Breaking the Screen: Interaction Across Touchscreen Boundaries in Virtual Reality for Mobile Knowledge Workers. IEEE Trans. Vis. Comput. Graph. 2020, 26, 3490–3502. [Google Scholar] [CrossRef] [PubMed]

- Ro, H.; Byun, J.H.; Park, Y.J.; Lee, N.K.; Han, T.D. AR Pointer: Advanced Ray-Casting Interface Using Laser Pointer Metaphor for Object Manipulation in 3D Augmented Reality Environment. Appl. Sci. 2019, 9, 3078. [Google Scholar] [CrossRef]

- Lee, L.H.; Zhu, Y.; Yau, Y.P.; Braud, T.; Su, X.; Hui, P. One-thumb Text Acquisition on Force-assisted Miniature Interfaces for Mobile Headsets. In Proceedings of the 2020 IEEE International Conference on Pervasive Computing and Communications (PerCom), Austin, TX, USA, 23–27 March 2020; IEEE: Piscataway, NJ, USA, 2020. [Google Scholar] [CrossRef]

- Chen, Y.; Katsuragawa, K.; Lank, E. Understanding Viewport- and World-based Pointing with Everyday Smart Devices in Immersive Augmented Reality. In Proceedings of the 2020 CHI Conference on Human Factors in Computing Systems, Honolulu, HI, USA, 25–30 April 2020; ACM: New York, NY, USA, 2020. [Google Scholar] [CrossRef]

- Fuvattanasilp, V.; Fujimoto, Y.; Plopski, A.; Taketomi, T.; Sandor, C.; Kanbara, M.; Kato, H. SlidAR+: Gravity-aware 3D object manipulation for handheld augmented reality. Comput. Graph. 2021, 95, 23–35. [Google Scholar] [CrossRef]

- Bozgeyikli, E.; Bozgeyikli, L.L. Evaluating Object Manipulation Interaction Techniques in Mixed Reality: Tangible User Interfaces and Gesture. In Proceedings of the 2021 IEEE Virtual Reality and 3D User Interfaces (VR), Lisboa, Portugal, 27 March–1 April 2021; IEEE: Piscataway, NJ, USA, 2021; pp. 778–787. [Google Scholar] [CrossRef]

- Besançon, L.; Sereno, M.; Yu, L.; Ammi, M.; Isenberg, T. Hybrid Touch/Tangible Spatial 3D Data Selection. Comput. Graph. Forum 2019, 38, 553–567. [Google Scholar] [CrossRef]

- Wacker, P.; Nowak, O.; Voelker, S.; Borchers, J. ARPen: Mid-Air Object Manipulation Techniques for a Bimanual AR System with Pen & Smartphone. In Proceedings of the 2019 CHI Conference on Human Factors in Computing Systems, Glasgow, UK, 4–9 May 2019; ACM: New York, NY, USA, 2019. [Google Scholar] [CrossRef]

- Nukarinen, T.; Kangas, J.; Rantala, J.; Koskinen, O.; Raisamo, R. Evaluating ray casting and two gaze-based pointing techniques for object selection in virtual reality. In Proceedings of the 24th ACM Symposium on Virtual Reality Software and Technology, Tokyo, Japan, 28 November–1 December 2018; ACM: New York, NY, USA, 2018. [Google Scholar] [CrossRef]

- Bâce, M.; Leppänen, T.; de Gomez, D.G.; Gomez, A.R. ubiGaze: Ubiquitous Augmented Reality Messaging Using Gaze Gestures. In Proceedings of the SIGGRAPH ASIA 2016 Mobile Graphics and Interactive Applications, Macau, 5–8 December 2016; ACM: New York, NY, USA, 2016. [Google Scholar] [CrossRef]

- Hassoumi, A.; Hurter, C. Eye Gesture in a Mixed Reality Environment. In Proceedings of the 14th International Joint Conference on Computer Vision, Imaging and Computer Graphics Theory and Applications—HUCAPP, Prague, Czech Republic, 25–27 February 2019; pp. 183–187. [Google Scholar] [CrossRef]

- Fikkert, W.; D’Ambros, M.; Bierz, T.; Jankun-Kelly, T.J. Interacting with Visualizations. In Proceedings of the Human-Centered Visualization Environments: GI-Dagstuhl Research Seminar, Dagstuhl Castle, Germany, 5–8 March 2006; Revised Lectures. Kerren, A., Ebert, A., Meyer, J., Eds.; Springer: Berlin/Heidelberg, Germany, 2007; pp. 77–162. [Google Scholar] [CrossRef]

- Al-Rahayfeh, A.; Faezipour, M. Eye Tracking and Head Movement Detection: A State-of-Art Survey. IEEE J. Transl. Eng. Health Med. 2013, 1, 2100212. [Google Scholar] [CrossRef] [PubMed]